Il dottor KI sotto la lente d'ingrandimento

Nuovi studi mostrano i punti di forza e di debolezza degli strumenti supportati dall'intelligenza artificiale per la consulenza sanitaria digitale, come ChatGPT o le app per il controllo dei sintomi

Annunci

I pazienti si rivolgono sempre più spesso a strumenti digitali per riconoscere le malattie e ricevere raccomandazioni di intervento. Due recenti studi della TU di Berlino hanno analizzato la qualità e l'efficacia di tali raccomandazioni sanitarie digitali. I risultati mostrano sia il potenziale che i rischi. Gli studi sono stati pubblicati sulle riviste Scientific Reports e npj Health Systems Journal.

Nel primo studio, un team guidato dal dottor Marvin Kopka del Dipartimento di Ergonomia della TU di Berlino ha sviluppato un nuovo metodo di test per valutare l'accuratezza delle raccomandazioni sulla salute fornite da ChatGPT e da altri modelli di intelligenza artificiale come Meta's LLaMa, oltre che da app di controllo dei sintomi appositamente sviluppate che interrogano i sintomi e forniscono raccomandazioni di intervento in base ad essi. Mentre i test precedenti si basavano su casi da manuale idealizzati che raramente si verificano nella realtà, il nuovo metodo si basa su casi reali di pazienti con cui gli scienziati della TU di Berlino hanno testato vari strumenti digitali. Ciò consente una valutazione più realistica della precisione e dell'utilità degli strumenti digitali nella pratica. "Il nostro metodo standardizzato può essere visto come una sorta di 'Stiftung Warentest', in quanto ci permette di confrontare l'accuratezza di diverse app, ma anche di identificarne i punti di forza e di debolezza", afferma il responsabile dello studio Marvin Kopka.

Le app per il controllo dei sintomi sono significativamente più utili

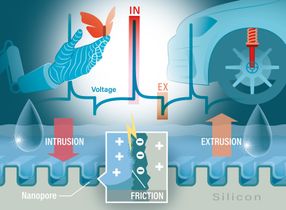

I risultati del nuovo metodo di valutazione mostrano che le app di controllo dei sintomi sono significativamente più utili per i non addetti ai lavori rispetto a ChatGPT, soprattutto quando si tratta di distinguere tra sintomi innocui e gravi. Mentre ChatGPT classifica quasi tutti i casi come emergenze o urgenze, le app specializzate sono in grado di fornire raccomandazioni più informate e appropriate nella maggior parte dei casi. Come già dimostrato da altri studi, ChatGPT è in grado di diagnosticare bene le malattie se sono disponibili i valori di laboratorio o i risultati degli esami. Tuttavia, poiché di solito questi non sono disponibili a casa, la diagnosi rimane spesso imprecisa e l'elenco di diverse possibili malattie suggerito dal modello è di scarso aiuto per i non addetti ai lavori. Raccomandazioni di intervento come "Vai dal medico" o "Chiama il 112" sono più decisive - tuttavia, ChatGPT si comporta male in questo caso, poiché classifica quasi tutti i casi come bisognosi di cure, anche in presenza di sintomi innocui.

I non addetti ai lavori di solito riconoscono le emergenze mediche in modo affidabile

I ricercatori hanno anche scoperto che I non addetti ai lavori di solito riconoscono le emergenze mediche in modo affidabile e chiamano i servizi di emergenza in casi gravi, come una grave lesione alla testa con vomito e vertigini. Tuttavia, hanno più difficoltà a riconoscere correttamente i sintomi innocui. Ad esempio, molte persone tendono a rivolgersi troppo rapidamente a un medico per disturbi minori come una diarrea di breve durata o una piccola alterazione della pelle, anche se spesso non è necessario. "Il fatto che sempre più persone utilizzino ChatGPT per avere consigli medici è dannoso per il sistema sanitario. L'intelligenza artificiale spesso spinge gli utenti a recarsi immediatamente dal medico o al pronto soccorso al minimo sintomo. Questo può portare a un sovraccarico massiccio", avverte il dottor Marvin Kopka, responsabile dello studio.

Gli utenti non accettano acriticamente le raccomandazioni digitali

Il secondo studio non solo ha messo a confronto persone e tecnologia, ma ha anche analizzato quanto accuratamente le persone incorporino le raccomandazioni di ChatGPT e delle app di controllo dei sintomi nelle proprie decisioni. Ne è emerso che gli utenti non accettano le raccomandazioni in modo acritico, ma le confrontano con altre fonti come le ricerche su Google, i consigli degli amici o altre app. "D'altra parte, ci sono anche casi in cui i pazienti ricevono dagli strumenti digitali troppe informazioni, talvolta incomprensibili, che non riescono a classificare. Questo crea ansia e quindi si rivolgono a un esperto al pronto soccorso o al medico di famiglia, anche per disturbi innocui, come raccomanda ChatGPT", spiega Kopka.

Prima di uno studio quantitativo con 600 soggetti, il secondo studio ha osservato 24 persone che utilizzano ChatGPT e poi ha modellato il modo in cui prendono decisioni con l'aiuto di ChatGPT e delle app. La valutazione ha dimostrato ancora una volta che ChatGPT rende più difficile l'autocura e aumenta il numero di visite inutili al medico. Al contrario, le app di controllo dei sintomi ben funzionanti hanno aiutato gli utenti a decidere a favore dell'autocura nei casi appropriati, contribuendo così a ridurre l'onere sul sistema sanitario. "La ChatGPT ha molte applicazioni utili, ma non è adatta a decidere se devo andare dal medico: è troppo imprecisa per questo", riassume Kopka. "Dovremmo chiederci se un'app ci aiuta a prendere buone decisioni, piuttosto che aspettarci la perfezione da essa. Dopo tutto, nella maggior parte dei casi le persone prendono già decisioni sicure e sensate. In alcune situazioni, tuttavia, si può trarre vantaggio dalle app".

Gli studi dimostrano che gli strumenti digitali possono essere utilizzati per supportare i pazienti nel loro processo decisionale. Le app per il controllo dei sintomi appositamente sviluppate si stanno attualmente dimostrando più utili dei modelli generativi di intelligenza artificiale come ChatGPT. Tuttavia, secondo i ricercatori, un approccio critico alle raccomandazioni digitali rimane fondamentale per evitare valutazioni errate e un inutile onere per il sistema sanitario.

Nota: questo articolo è stato tradotto utilizzando un sistema informatico senza intervento umano. LUMITOS offre queste traduzioni automatiche per presentare una gamma più ampia di notizie attuali. Poiché questo articolo è stato tradotto con traduzione automatica, è possibile che contenga errori di vocabolario, sintassi o grammatica. L'articolo originale in Tedesco può essere trovato qui.

Pubblicazione originale

Marvin Kopka, Hendrik Napierala, Martin Privoznik, Desislava Sapunova, Sizhuo Zhang, Markus A. Feufel; "The RepVig framework for designing use-case specific representative vignettes and evaluating triage accuracy of laypeople and symptom assessment applications"; Scientific Reports, Volume 14, 2024-12-23

Marvin Kopka, Sonja Mei Wang, Samira Kunz, Christine Schmid, Markus A. Feufel; "Technology-supported self-triage decision making"; npj Health Systems, Volume 2, 2025-1-25