Confiar en la IA pero no a ciegas

La inteligencia artificial a veces es recibida con escepticismo pero se ha ganado nuestra confianza

Un equipo de investigación de la Universidad Técnica de Darmstadt dirigido por el profesor Kristian Kersting describe cómo lograrlo utilizando un enfoque inteligente de aprendizaje interactivo en la revista "Nature Machine Intelligence".

Imagen simbólica

geralt, pixabay.com

Imagina la siguiente situación: Una empresa quiere enseñar a una inteligencia artificial (IA) a reconocer un caballo en las fotos. Para ello, utiliza varios miles de imágenes de caballos para entrenar la IA hasta que sea capaz de identificar con fiabilidad al animal incluso en imágenes desconocidas. La IA aprende rápidamente - no está claro para la compañía cómo está tomando sus decisiones pero esto no es realmente un problema para la compañía. Simplemente está impresionada por la fiabilidad del proceso. Sin embargo, una persona sospechosa descubre que la información de copyright con un enlace a un sitio web sobre caballos está impresa en la esquina inferior derecha de las fotos. La IA ha hecho las cosas relativamente fáciles para sí misma y ha aprendido a reconocer al caballo basándose sólo en este aviso de copyright. Los investigadores hablan en estos casos de factores de confusión que no deberían tener nada que ver con el proceso de identificación. En estos casos, el proceso funcionará mientras la IA siga recibiendo otras fotos comparables. Si falta el aviso de copyright, la IA se deja en seco.

Diversos estudios realizados en los últimos años han estudiado y demostrado cómo descubrir esta indeseada toma de decisiones de los sistemas de IA, incluso cuando se utilizan conjuntos de datos muy grandes para entrenar el sistema. Se han conocido como momentos de "Hans el inteligente" de la IA, llamados así por un caballo que a principios del siglo pasado se suponía que era capaz de resolver simples sumas aritméticas, pero que en realidad sólo era capaz de encontrar la respuesta correcta "leyendo" el lenguaje corporal del que preguntaba. "La IA con un momento de "Clever Hans" aprende a sacar las conclusiones correctas por las razones equivocadas", dice Kristian Kersting, Profesor de Inteligencia Artificial y Aprendizaje Automático en el Departamento de Informática de la Universidad Técnica de Darmstadt y miembro de su Centro de Ciencia Cognitiva. Este es un problema al que todos los investigadores de la IA se enfrentan potencialmente y deja claro por qué el llamamiento a una "IA explicable" se ha hecho más fuerte en los últimos años.

Kersting comprende las consecuencias de este problema: "Eliminar los momentos de "Clever Hans" es uno de los pasos más importantes hacia la aplicación práctica y la difusión de la IA, en particular en las áreas científicas y en las áreas críticas para la seguridad". El investigador y su equipo ya han estado desarrollando soluciones de IA durante varios años que pueden determinar la resistencia de una planta a los parásitos o detectar una infestación en una etapa temprana, incluso antes de que pueda ser percibida por el ojo humano. Sin embargo, el requisito previo para el éxito de esa aplicación es que el sistema de IA sea adecuado por las razones científicas correctas, de modo que los expertos del dominio confíen realmente en la IA. Si no es posible generar confianza, los expertos se apartarán de la IA - y por lo tanto perderán la oportunidad de utilizarla para crear plantas resistentes en tiempos de calentamiento global.

No obstante, hay que ganarse la confianza. En un artículo reciente publicado en la revista "Nature Machine Intelligence", el investigador y su equipo demuestran cómo se puede mejorar la confianza en la IA mediante el aprendizaje interactivo. Esto significa integrar a los expertos en el proceso de aprendizaje. Estos expertos necesitan ser capaces de entender qué es lo que la IA está haciendo realmente. Más precisamente, el sistema de la IA tiene que proporcionar información sobre su proceso de aprendizaje activo, por ejemplo, qué información ha tomado de un conjunto de entrenamiento como la imagen de un caballo y una explicación de cómo es capaz de hacer una predicción basada en esta información. Las personas con conocimientos expertos pueden entonces comprobar ambas cosas. Si la predicción es fundamentalmente errónea, la IA puede aprender nuevas reglas, pero si la predicción y la explicación son correctas, los expertos no necesitan hacer nada. Sin embargo, los expertos se quedan con un problema si la predicción es correcta pero la explicación es incorrecta: ¿Cómo se le enseña a una IA que la explicación es incorrecta?

Junto con colegas de la Universidad de Bonn, la Universidad de Göttingen, la Universidad de Trento y la empresa LemnaTec, el equipo ha desarrollado ahora un novedoso enfoque para este fin que se denomina "aprendizaje interactivo explicativo" (XIL). En términos sencillos, añade al experto en el bucle de formación de tal manera que revisa interactivamente el sistema de IA mediante la retroalimentación de sus explicaciones. En el ejemplo descrito anteriormente, la IA indicaría que considera que la información sobre los derechos de autor es pertinente. El experto simplemente dirá "no, esto no está bien". Como resultado, la IA prestará cada vez menos atención a esta información en el futuro.

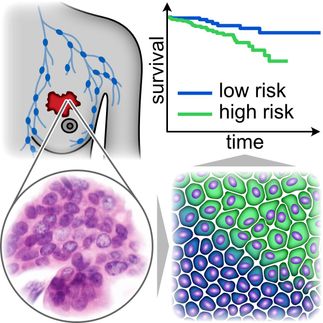

Apoyado por el Ministerio Federal de Alimentación y Agricultura (BMEL), el equipo de investigación de la Universidad Técnica de Darmstadt probó el XIL utilizando un conjunto de datos para la enfermedad de la mancha de la hoja de la Cercospora, una enfermedad dañina de la hoja de la remolacha azucarera que se encuentra en todo el mundo. La IA - una red neuronal convolucional (CNN) - aprendió inicialmente a concentrarse en áreas de los datos hiperespectrales que no podían ser relevantes para identificar el patógeno según los expertos en plantas - a pesar de que las predicciones eran muy precisas. Tras una etapa de corrección mediante el aprendizaje interactivo explicativo (XIL), la tasa de detección se sintió sólo ligeramente, pero la IA sacó las conclusiones correctas por las razones adecuadas. Los expertos son capaces de trabajar con este tipo de IA. Por el contrario, la IA puede aprender a un ritmo más lento, pero proporcionará predicciones más fiables a largo plazo.

"La interacción y la comprensibilidad son, por lo tanto, crucialmente importantes para generar confianza en los sistemas de IA que aprenden de los datos", dice Kersting. Sorprendentemente, los vínculos entre la interacción, la explicación y el fomento de la confianza han sido en gran medida ignorados en la investigación, hasta ahora.

Nota: Este artículo ha sido traducido utilizando un sistema informático sin intervención humana. LUMITOS ofrece estas traducciones automáticas para presentar una gama más amplia de noticias de actualidad. Como este artículo ha sido traducido con traducción automática, es posible que contenga errores de vocabulario, sintaxis o gramática. El artículo original en Inglés se puede encontrar aquí.

Publicación original

Patrick Schramowski, Wolfgang Stammer, Stefano Teso, Anna Brugger, Franziska Herbert, Xiaoting Shao, Hans-Georg Luigs, Anne-Katrin Mahlein & Kristian Kersting; "Making deep neural networks right for the right scientific reasons by interacting with their explanations"; Nature Machine Intelligence; 2, 476-486 (2020).